Ученые-католики обучили Искусственный Интеллект надевать трусы на фото голых женщин в интернете

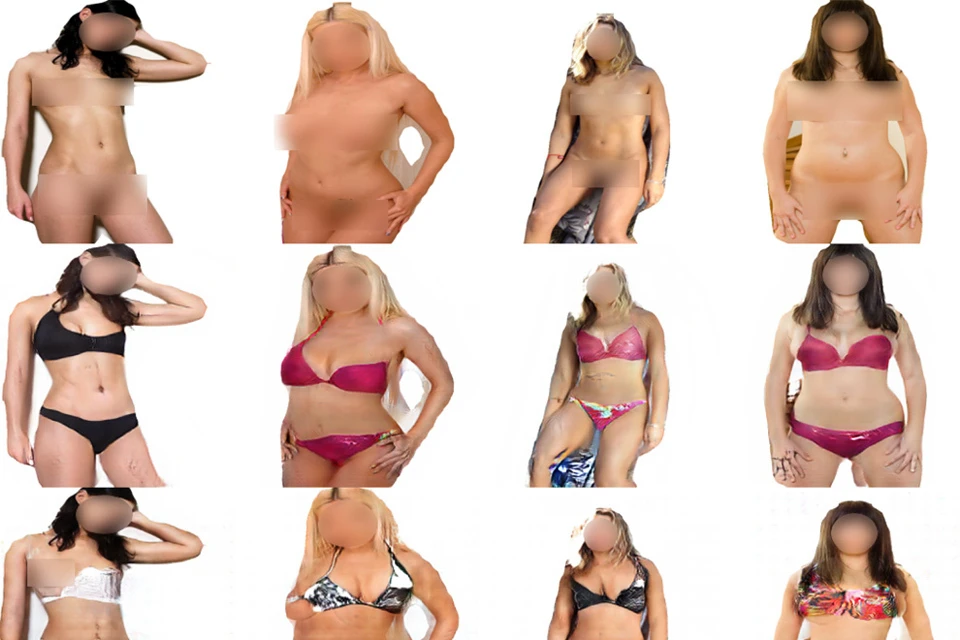

Результаты работы искусственного интеллекта пусть и далеки от совершенства, но всё же впечатляют.

Взрослым ценителям женских прелестей пока не о чем беспокоиться. Свое ноу-хау ученые из Папского католического университета Рио Гранди ду Сул (Бразилия) разрабатывали для защиты от соблазна неокрепших детских умов. Католические программисты рассуждали вполне логично: сегодня интернет становится доступен для детей с самого раннего возраста. И очень часто Сеть подсовывает пользователям контент, который для них явно не предназначен - например, порнографические картинки. Исследователи приводят такие цифры: 93,2% несовершеннолетних мальчиков и 62,1% девочек видели порно в интернете. При этом 8 из 10 опрошенных подростков заявили, что в сети слишком велика вероятность случайного знакомства с картинками для взрослых (поверим им на слово, что банальное любопытство здесь ни при чем). Существующие технологии контроля, как правило, полностью блокируют доступ к ресурсу, содержащему фото обнаженных людей или порно. Но тотальный запрет лишь подогревает интерес к запретному плоду, тем более, что обойти блокировку современному продвинутому ребенку не составляет ни малейшего труда.

- На наш взгляд цензура не должна быть навязчивой. Мы разработали новый тип фильтрации непристойного контента, - говорит профессор католического университета Родриго Баррош. - Наш алгоритм подвергает цензуре не все изображение целиком, а только те части тела, которые могут ввести человека в искушение. Проще говоря, мы научили искусственный интеллект (ИИ) распознавать фотографии обнаженных женщин и возвращать им вполне невинный вид, одевая их в бикини.

Католические ученые разработали новый тип фильтрации непристойного контента в интернете.

Результаты своих экспериментов Баррош и его коллеги представили на Международной конференции по нейронным сетям в Рио-де-Жанейро. Для обучения нейросети (это тип искусственного интеллекта, который способен самосовершенствоваться, выполняя те или иные задачи), бразильские ученые использовали несколько тысяч женских фотографий. Сначала математическая модель анализировала карточки полностью голых девиц. Затем разглядывала девушек в бикини и училась различать , чем «развратницы» отличаются от «скромниц». Это было необходимо, чтобы ИИ научился выделять конфигурацию пикантных мест женского тела, которые необходимо закрыть купальником.

Однако, искусственный интеллект оказался не слишком строгим цензором. В ряде случаев нарисованные компьютером бикини явно не закрывали все дамские прелести. У некоторых барышень были приспущены трусики, в других случаях нейросеть не смогла правильно надеть на красавиц лифчик.

- Мы еще в самом начале пути и пока алгоритм работает не очень надежно, - успокаивает профессор Баррош, - Но, думаю, в перспективе наше решение будет встроено в интернет-браузеры для защиты аудитории от нежелательного контента.

Но существует еще один нюанс. Нейросеть научилась не только одевать обнаженных «проказниц» в бикини, но и наоборот - снимать купальники с респектабельных дам. Причем, раздевать женщин у искусственного интеллекта получается куда лучше, чем одевать (показать мы этого не можем, но поверьте на слово). Его конечно, можно понять. Но исследователи из католического университета опасаются, что их технология может быть использована кибер-преступниками для создания поддельной порнографии. Причем, под раздачу попадут не только «звезды» и знаменитости. Любая девушка, выложившая в соцсети свое фото с пляжного отдыха, рискует, что из невинной карточки компьютерные хулиганы могут сделать компромат. Ученые уверяют, что они вовсе не закладывали в программу функцию раздевания людей, это просто побочный эффект новой технологии. Что лишний раз доказывает, что к работам в области искусственного интеллекта нужно подходить крайне осторожно.